10-GBit-NAS-Setup im Test

Ohne Tempolimit

Die Komponenten der Computertechnik entwickeln sich oft mit einem Tempo, das jede Vorstellung sprengt. Der erste 4-Bit-Mikroprozessor, Intels 4004, bestand 1971 aus ganzen 2300 Transistoren. Heute, rund 40 Jahre später, kommen dagegen auf Intel-Core-CPUs fast anderthalb Milliarden unter, über 600 000mal so viele. Könnte man selbst das höchste Gebäude der Welt in demselben Maß verkleinern wie diese Transistoren, man müsste es nicht mit der Lupe suchen, man bräuchte ein gutes Mikroskop.

Diese rasante Entwicklung hat allerdings ein Problem: Sie vollzieht sich nicht gleichmäßig für alle Kernbestandteile eines Rechners.

Das Problem

Etwa zur selben Zeit wie die ersten 8-Bit-Prozessoren, die auf den 4004 folgten, startete IBM das Projekt Winchester, dessen Name lange als Synonym für Festplatten galt. Das erste Winchester-Laufwerk, das IBM 3340, fasste 35 oder 70 MByte und konnte Daten mit einer Zugriffsgeschwindigkeit von 25 Millisekunden bereitstellen. Die Kapazität hat sich im Vergleich zu heute somit nur um einen rund zehnmal kleineren Faktor gesteigert als die Transistorenanzahl. Noch sehr viel schlechter sieht es bei der Zugriffszeit aus: Weil sich die Rotationsgeschwindigkeit der Platten aus physikalischen Gründen nicht beliebig erhöhen lässt, sank die mittlere Zugriffszeit in den letzten vier Jahrzehnten gerade mal auf rund ein Zehntel der historischen Ausgangsmarke.

Den Ausweg aus diesem Dilemma weisen SSDs. Weil sie ohne mechanische Teile auskommen, lassen sich mit ihnen Zugriffszeiten von 0,08 bis 0,16 ms realisieren. Das ist zwar ebenfalls noch sehr weit entfernt von Verhältnis der Transistoren, aber immerhin ist die benötigte Zeit rund 30mal kürzer als bei einer modernen Platte. Damit sind Transferleistungen beim sequenziellen Lesen von rund 500 MByte/s möglich.

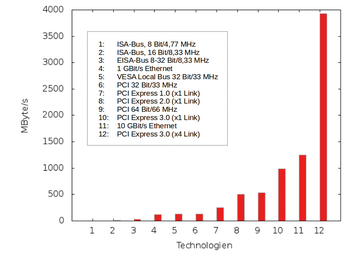

Doch schon ergibt sich das nächste Problem: Für einen SSD-bestückten Fileserver wäre nun das Gigabit-Netzwerk zu langsam, dass ebenfalls nicht ganz Schritt gehalten hat. Ein aktuelles Gigabit-Netz ist gerade mal 100mal so schnell wie die ersten Ethernet-Standards (10Base5/10Base2/10Base-T) mit ihren 10 MBit/s. Inzwischen kann man sich mit 10-GBit-Ethernet behelfen (und 40 sowie 100 GBit stehen vor der Tür), aber weil man immer wieder eine Lücke reißt, sobald man eine stopft, muss man dabei dann schon auf die Performance der Bus-Systeme schauen ( Abbildung 1 ) …

Standards

10-GBit-Ethernet wird im über 500 Seiten starken Standard IEEE 802.3ae-2002 definiert [1] , der im Juni 2002 verabschiedet wurde. Zuerst bezog er sich nur auf verschiedene Glasfaserverbindungen mit Längen ab 300 Meter und bis zu 40 Kilometer ( Tabelle 1 ). Zwei Jahre später, 2004 (802.3ak-2004) [2] , kamen auch Kupferverbindungen als physikalische Interfaces hinzu. Zunächst über Kabel, wie sie auch Infiniband benutzt 10GBASE-CX4 (bis 15m) beziehungsweise über SFP+-Verbindungen. Im Jahr 2006 erweiterte sich das Angebot um 10GBASE-T (mit der Norm IEEE 802.3an-2006) [3] , das die Verwendung von Unshielded-Twisted-Pair-Kabeln mit RJ45-Steckern erlaubt, wie sie prinzipiell auch bei den Ethernet-Vorläufern im Einsatz waren. Mit Kabeln der Kategorie 6A oder besser sind damit Entfernungen bis zu 100 Metern möglich.

Tabelle 1

Physische Interfaces

|

Typ |

Wellenlänge (nm) |

max. Distanz (m) |

Anwendung |

|---|---|---|---|

|

10GBASE-LX4 |

1310 |

Multimode: 300, Mono: 10 000 |

kaum benutzt |

|

10GBASE-SR |

850 |

Multimode: 82, Mono: 300 |

Rechenzentren |

|

10GBASE-LR |

1310 |

Mono: 10 000 |

Metro Campus |

|

10GBASE-ER |

1550 |

Mono: 40 000 |

Metro WAN |

|

10GBASE-SW |

850 |

Mono: 300 |

Gebäude, vertikal |

|

10GBASE-LW |

1310 |

Mono: 10 000 |

Rechenzentren/Backbone |

|

10GBASE-EW |

1550 |

Mono: 40 000 |

Rechenzentren/Backbone |

Alle 10-GBit-Spielarten unterstützen übrigens nur noch Vollduplex-Punkt-zu-Punkt-Verbindungen und Switche, Halbduplex-Verbindungen und Hubs gibt es hier nicht mehr.